GPU 适合某些情景下的并行运算,因为计算核心比 CPU 多。

这些场景一般可以将计算过程分为互不依赖的更小的子过程进行并行处理,称为 embarrassingly parallel

Torch 创始人大佬就说

神经网络是 embarrassingly parallel

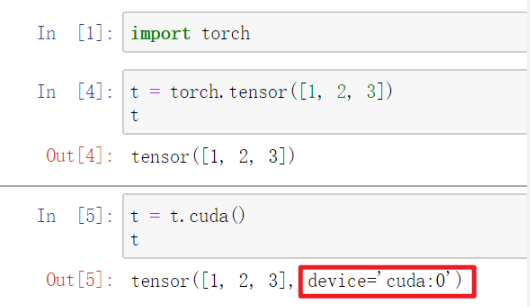

张量由 CPU 计算转 GPU 计算

t = torch.tensor([1, 2, 3])

# 使用 CUDA

t = cuda()

红框表示你可以使用多个显卡,当前使用显卡 0

转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。可以在下面评论区评论。